En marche vers une « gadgétisation » des droits culturels avec Françoise Nyssen ?

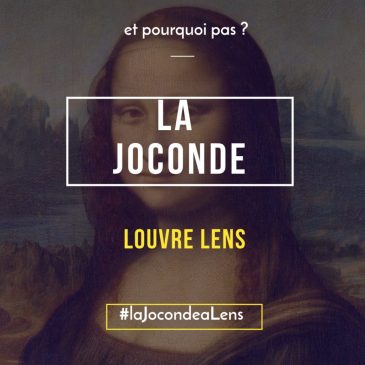

Voilà bientôt une dizaine de jours qu’une polémique a éclaté à propos de l’idée de faire voyager La Joconde en France. Le gouvernement semble envisager cette possibilité en dépit des avis défavorables des experts eu égard aux risques de détérioration de l’oeuvre et au coût exorbitant d’une telle opération (30 millions d’euros !). C’est pourtant … Lire la suite En marche vers une « gadgétisation » des droits culturels avec Françoise Nyssen ?